标准差是离均差平方的算术平均数(即:方差)的算术平方根,用σ表示。标准差也被称为标准偏差,或者实验标准差,在概率统计中最常使用作为统计分布程度上的测量依据。

标准差的含义

标准差,中文环境中又常称均方差,是离均差平方的算术平均数的平方根,用σ表示。在概率统计中最常使用作为统计分布程度上的测量。

标准差是方差的算术平方根。标准差能反映一个数据集的离散程度。平均数相同的两组数据,标准差未必相同;原因是它的大小,不仅取决于标准值的离差程度,还决定于数列平均水平的高低。

因而对于具有不同水平的数列或总体,就不宜直接用标准差来比较其标志变动度的大小,而需要将标准差与其相应的平均数对比,计算标准差系数,即采用相对数才能进行比较。

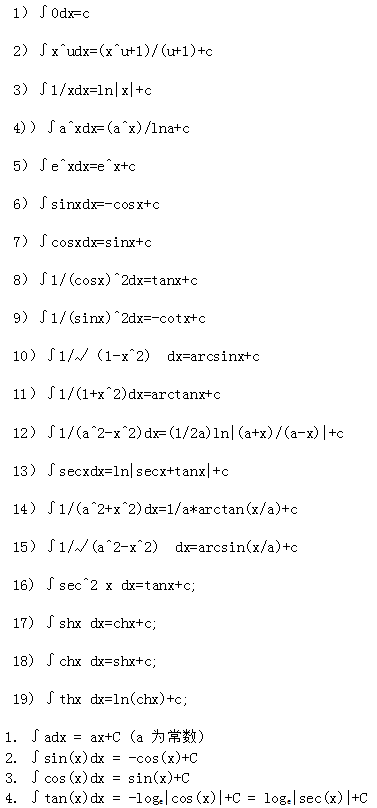

标准差的计算公式是什么

标准差公式是一种数学公式。标准差也被称为标准偏差,或者实验标准差,公式如下所示:

标准差计算公式:标准差σ=方差开平方。

样本标准差=方差的算术平方根=s=sqrt(((x1-x)^2 +(x2-x)^2 +......(xn-x)^2)/(n-1))。

总体标准差=σ=sqrt(((x1-x)^2 +(x2-x)^2 +......(xn-x)^2)/n )。

注解:上述两个标准差公式里的x为一组数(n个数据)的算术平均值。当所有数(个数为n)概率性地出现时(对应的n个概率数值和为1),则x为该组数的数学期望。